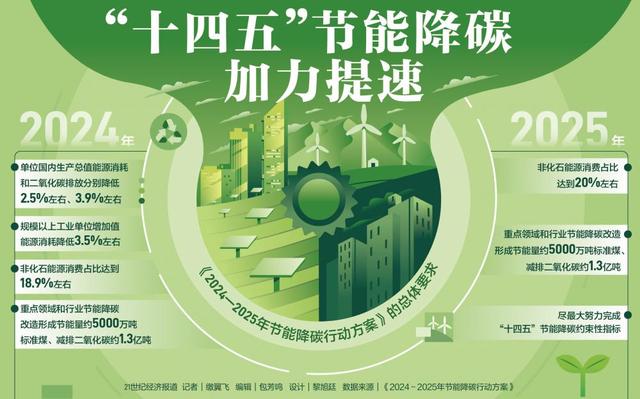

国务院关于印发《2024—2025年节能降碳行动方案》的通知

求解数据中心节能:东数如何“细”算?

求解数据中心节能:东数如何“细”算?前言:实施[东数西算]工程,推动数据中心合理布局、绿色集约和互联互通,具有多方面意义。不过伴随各行业对数据中心的需求持续增长,是不断攀升的能源消

前言:

实施[东数西算]工程,推动数据中心合理布局、绿色集约和互联互通,具有多方面意义。

不过伴随各行业对数据中心的需求持续增长,是不断攀升的能源消耗。

作者|方文三

图片来源|网络

行业规模扩张能耗持续走高

数据中心的能耗和碳排放贯穿其全生命周期过程。

其中,运营阶段的能耗和排放最多,排放源包括机房内服务器和空调设备的运行、办公区域人员以及其他装置设备用电等。

据生态环境部环境规划院测算,到2025年,全国数据中心机架规模将达759万架,较2021年增长40%,能源消耗总量达3500亿千瓦时,较2021年增加62%,约占全社会用电量的4%。

据《中国[新基建]发展研究报告》显示,到2025年,全球数据中心将占全球能耗的最大份额,高达33%。

在国内,全国数据中心的耗电量已经连续八年以超过12%的速度增长。

数据中心节能技术主要分类

为了应对能耗增长过快的问题,数据中心的节能技术不断涌现,当前主要的技术分为以下几类。

①充分利用自然冷源:当过渡季节室外温度低于室内温度时,自然界存在着丰富的冷源,如何利用大自然的冷源进行冷却是机房空调节能减排的重点问题。

一是间接空气交换;二是直接空气交换。

2017年底,阿里巴巴千岛湖数据中心正式投入使用,是国内首个采用自然水制冷技术的数据中心,空调系统采用两路进水,湖水和冷冻水,可以实现同时或单独运行。

湖水经过物理净化后,通过密闭管道流经每层为服务器降温,之后直接供市政景观用水,实现了资源最佳利用,预计年均PUE可达1.3。

②高密度数据中心可以考虑液冷:数据中心数据中心液冷技术与传统风冷技术相比,系统耗电量约节省30%以上,应用液冷技术的数据中心机房整体能效同时得到30%的提升。

曙光节能技术有限公司从液冷技术入手,研发冷板式液冷服务器、浸没式液冷服务器,采用的[相变液冷]技术的服务器产品,PUE值可降到1.05以下。

③尽量利用可再生清洁能源:可再生能源发电是高度模块化的,可以逐渐增加发电容量以匹配负载的增长。此外,系统筹建时间要比传统的发电厂短得多,降低了投资和监管的风险。

中国电信针对新建大型、超大型数据中心,探索试点应用业界新技术,包括蒸发冷、热管多联、液冷等高效空调节能技术,智能小母线、分布式供电等高效供配电方案。

去年双11期间,阿里巴巴张北数据中心通过使用可再生能源,减少了超过2.6万吨二氧化碳排放。

④注重数据中心的余热利用:当前数据中心主要回收冷冻水回水对余热进行二次利用,代替传统市政供热设施,从而达到减少煤炭等燃料的燃烧。

位于日德兰半岛的新建的苹果公司数据中心,计划回收利用其余热,以满足当地部分供暖负荷。

⑤光伏发电节约额外用电:数据中心可在楼顶加装光伏发电,虽然不能直接对数据中心供电,但可以供给照明、其他办公区域用电。

2014年建设的腾讯上海青浦数据中心,安装了分布式光伏系统供电给数据中心园区负载使用。

2016年北京中经云亦庄数据中心,楼顶安装800kW光伏发电为生活热水、夏季空调使用等提供电力。

目前,在京东华东、华北数据中心,运用能源回收及大规模分布式光伏发电系统,构建清洁低碳安全高效的能源体系。

⑥技术革新智慧升级:中国电信针对新建大型、超大型数据中心,探索试点应用业界新技术,包括蒸发冷、热管多联、液冷等高效空调节能技术,智能小母线、分布式供电等高效供配电方案。

从2021年开始,中国联通河南分公司联合中兴通讯等多方合作,进行数据中心的改造计划。

改造计划包括采用VRM智能双循环氟泵多联空调、iDCIM系统和智能母线等方案。

帮助二长数据中心提升20%资源利用率,减少50%运维工时,实现高效低成本运维。

⑦模块化和预制化路线:数据中心的制冷、配电架构将从传统的分级化结构向高度融化的方向演进。

大量的预制化、模块化的节能产品将会不断涌现以满足数据中心快速上线、弹性增容、高效节能要求。

华为廊坊基地云数据中心是我国首栋采用装配式全预制模块化模式建设的数据中心。

将AI、信息技术和传统的电子电力技术、暖通技术相结合;通过气流管理提高冷却效率等技术,来提高数据中心的能源使用效率。

⑧布局智能化管理系统:自动设计、在线仿真、AI能效优化,AI运维与巡检、预测性维护、实时调节参数等技术将促使数据中心节能朝着智能化的方向发展。

华为云乌兰察布数据中心是全球首个批量部署FusionPOD液冷服务器的云数据中心。

同时,该数据中心结合间接蒸发冷却技术,充分利用自然冷源;

结合AI能效调优技术,可随业务功率变化实时调整制冷功率,进一步提升5%至8%效率。

腾讯云仪征东升数据中心在设计时还应用了最新一代T-block(腾讯积木)技术。

用标准化、模块化的概念;利用高压直流、间接冷蒸发、AI调优等技术,把全年的平均PUE控制在非常低的水平。

液冷方式被看好市场过千亿

从能耗的角度看,整个数据中心的能耗当中电力是最大一部分,而电力部分中40%到60%是由空调引起。

所以如何降低空调的耗电将是决定数据中心能耗的一个关键点。

现在数据中心节能的要求,要把PUE从1.4、1.5降到1.2甚至1.15,显然目前的制冷方式不能满足,且主流制冷方式受气候条件限制较大。

因此,液冷的制冷方式呼之欲出。有市场分析机构预计,到2026年,液冷数据中心市场的初始估值从2018年的14.3亿美元增至1205亿美元。

根据调研机构赛迪数据显示,未来浸没式液冷的市场占比将逐步提升,将从2019年的不到20%增长到2025年的40%以上。

需更加关注基础设施之外的能耗

数据中心节能更多是围绕机房、动力、基础设施建设和运维开展的,而对占比达到80%的基础设施之外的能耗关注的过少。

所以不但要关注电能使用指标,更要关注IT系统的能耗指标。

推动建立IT设备能耗评价体系,鼓励低能耗高算力的IT设备进场;

关注数据中心能耗到算力的整体转换能力,提升整个数据中心的效率。

在运营中,数据中心应该把IT设备的风扇与机房内的末端空调、通风地板甚至诱导风机相关联,与温度传感器一起,形成整体的联动,达到最佳的节能效果。

目前的AI节能都是基础设施部分的小循环,虽然看似达到最优,但是缺少关键的IT节点,其实有很大的局限性。

结尾:

虽然西部地区可再生能源丰富,有利于数据中心[转绿],不过,目前我国[绿电]占全国发电总量的比例还不算高。

通过建设绿色数据中心来降低功耗和运营成本,势在必行。

部分资料参考:数据中心基础设施运营管理:《数据中心节能的发展趋势与规划步骤》,CDCC:《数据中心节能改造难点及主要节能方向分析》

原文标题 : AI芯天下丨分析丨求解数据中心节能:东数如何[细]算?

-

浙江发改委下发2015年全省光伏发电项目计划通知2024-08-16

-

河南省陕县观音堂镇马头山20兆瓦光伏发电项目开工2024-08-16

-

中硅高科与洛宁县人民政府签订光伏发电项目战略合作协议2024-08-16

-

中节能新疆哈密景峡50MWp光伏发电项目环境影响报告表通过环评审2024-08-16

-

首航节能姚志豪:光热是“一带一路”好切入点2024-08-16

-

欧姆龙将上市触摸操作式光伏发电监控器,还支持输出控制2024-08-16

-

河南长葛首家个人光伏发电并网2024-08-16

-

今年河南风电和光伏发电装机容量计划突破210万千瓦2024-08-16

-

风电项目节能评估方法简介2024-08-16

-

林伯强:节能减排或成能源互联网领域最快实现内容2024-08-16

-

光伏发电助扶贫2024-08-16

-

风电项目节能评估方法简介2024-08-16

-

林伯强:节能减排或成能源互联网领域最快实现内容2024-08-16

-

财政部:节能减排补助资金专款专用 不得挪用2024-08-16

-

2019年光伏发电电价预测浅析2024-08-16