五部门关于开展2024年新能源汽车下乡活动的通知

摄像头摆烂,毫米波雷达罢工,自动驾驶静态识别还得靠它?

摄像头摆烂,毫米波雷达罢工,自动驾驶静态识别还得靠它?摄像头摆烂,毫米波雷达罢工,自动驾驶静态识别还得靠它?多花点儿钱就能解决。小鹏撞完特斯拉撞,特斯拉撞完理想撞,上周对于新势力们

摄像头摆烂,毫米波雷达罢工,自动驾驶静态识别还得靠它?多花点儿钱就能解决。

小鹏撞完特斯拉撞,特斯拉撞完理想撞,上周对于新势力们来说,可谓是黑色一周,智能驾驶的安全性问题再一次被提到了风口浪尖,科技一定是要以安全为底线的。

其实我们从上周的这几起新势力们有代表性的事故中,不难发现,一个老生常谈的话题——静态物体的识别问题,那么为什么到了2022年下半年,这个问题依然改观不大?背后有哪些行业上的痛点?

2022年8月了,静态识别还没有长进?

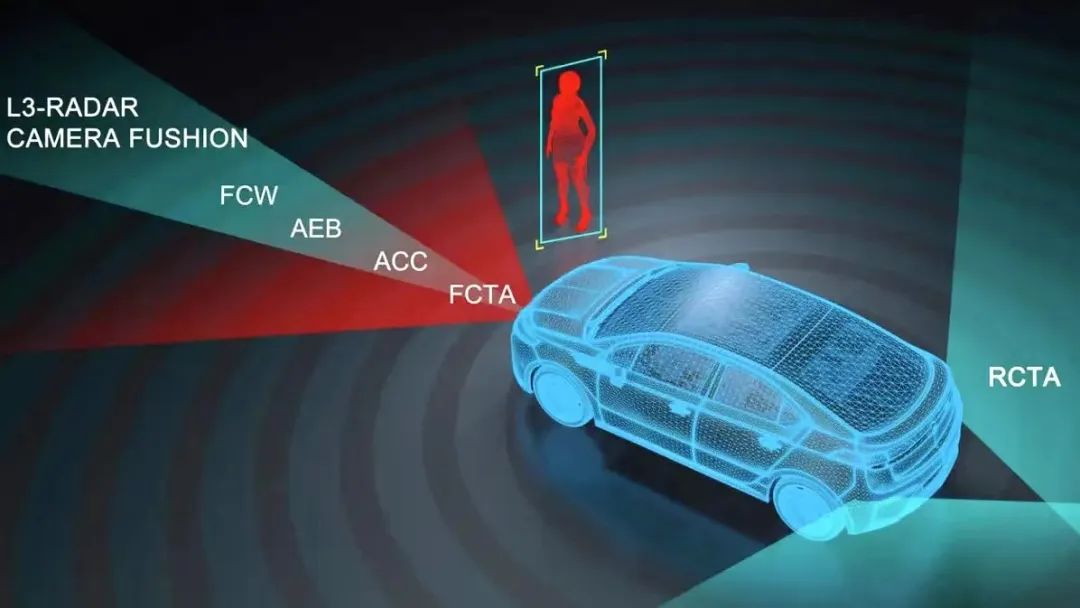

首先我们来看看发生事故的这几辆车,小鹏P7、特斯拉Model Y和2021款理想ONE,它们的智能驾驶感知系统都是以视觉为主导的,也就是其他比如毫米波雷达、超声波雷达系统都是用作辅助的,并且它们都没有搭载激光雷达。

其实目前主流的智能驾驶系统的工作逻辑和我们人类驾驶比较类似,通过视觉途径来感知周围的物体,利用中央计算平台完成数据处理,而后再像各个工作模块发出指令,而目前整套智能驾驶系统的处理速度,反应速度或者感知能力甚至会强于人类,面对大部分情况,几乎没有延迟就可以处理好。

但咱们这里强调的是大部分情况,而静止物体就是那少部分情况中的一种。

视觉感知,竟然会“摆烂”?

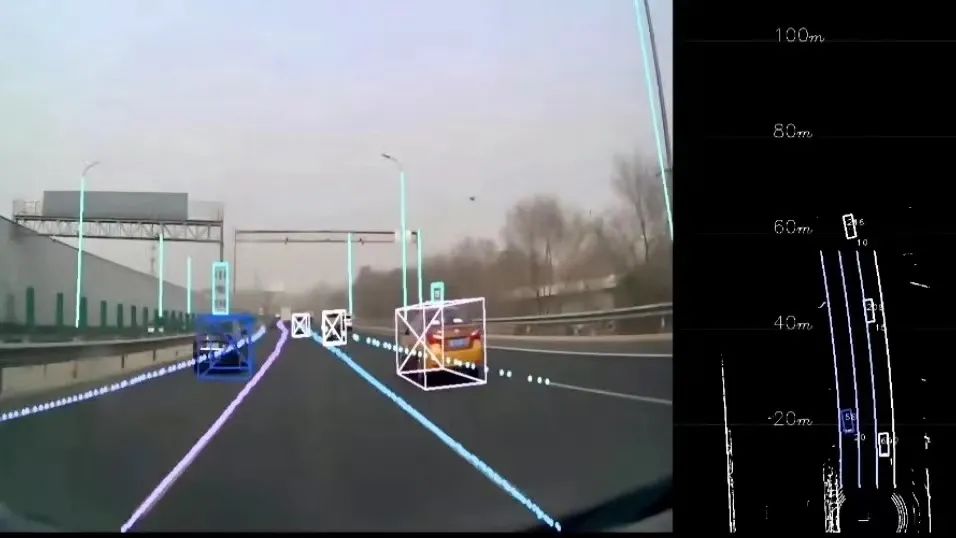

那么第一个就要从视觉层面入手,为什么高速快速路上的静止物体会成为系统不认识的物体?摄像头是可以认得出这里有个东西的,但是它和我们人类的逻辑不同,系统的眼睛在处理场景时对物体的感知和分类或者说是辨别,是协同工作的,如果眼睛看到的一个东西,但辨别不出物体,系统可能就会则会默认过滤掉这个信息,说直白些就是既然不认识,那就等于不存在,直接摆烂。

我们看到的特种车辆、不同样式的工作车或者改装车等等,视觉感知如果无法做到准确的识感知和分类,来不及处理势必带来危险。在高速上,智能驾驶的感知算法可能感知到前方的静止物体,但跟踪算法可能无法做到,这也可能导致在遇到静止物体时,整个传感器的计算无法做到瞬时收敛,然后它就躺平了。

这一点依然是个行业内的重难点,因为任何车企或者公司都无法做到,能让系统认清楚自己看到的每一个物体,所以它们只好把看到的物体,通过不断训练的神经网络,来完成数据标注、分类、定义,给这类物体赋予一个标签,这种分类方式可以极大程度的让系统能够在现有条件下尽可能多的认识物体,但依然确保十全十美。就像智己L7智能驾驶的开发者,为了让智己L7认清楚各种大货车,已经让系统自学习了上万种大货车的样貌,但这依然很难做到万无一失,总有一些漏网之鱼,而这些漏网之鱼就是智能驾驶发展过程中的拦路虎。

当然,车企们也鼓励用户们在日常驾驶中多用自家的智能驾驶功能,因为这样可以多获取一些用户数据,让车辆多学习,特斯拉使用的这种方式,其他新势力们也直接照搬了过来,毕竟数据越多,学得越多,犯错应该会变得更少。

首页 下一页 上一页 尾页-

混合动力系统分类2023-11-30

-

混合动力系统分类2023-11-30

-

新能源和智能化成汽车业“新风口”2023-11-30

-

混合动力汽车动力系统有缺点对比分析2023-11-30

-

博通集成:公司的Wi-Fi产品可用于智能家电市场、无人机与航模市场、新能源车、电工市场等物联网领域2022-08-16

-

许继电气:公司目前涉及国际业务的板块有智能电表、智能变配电、电动汽车智能充换电等2022-08-15

-

华盛锂电:公司的锂电池电解液添加剂产品最终应用于储能系统、新能源汽车、移动基站电源、3C电子等2022-08-15

-

马斯克的Master plans:电动超跑,大众电动车,AI智能汽车和机器人,后续?2022-08-15

-

安洁科技:公司主要研发和生产新能源汽车大功率无线充电系统 不属于快充2022-08-15

-

先有特斯拉,后有小鹏,高级辅助驾驶系统还值得让人信任吗?2022-08-14

-

电动车智能化的“致命”代价:小鹏LCC被误当自动驾驶2022-08-14

-

拓普集团:拟对子公司拓普电动车热管理系统公司增资25亿元2022-08-14

-

智能电动汽车竞争进入“下半场” 看比亚迪如何构建“护城河”?2022-08-14

-

松芝股份:目前公司已经为新能源汽车配套空调系统、散热器、空调箱以及部分电池热管理系统和零部件产品2022-08-10

-

未来万亿规模,汽车智能化市场是怎么炼成的?2022-08-10