五部门关于开展2024年新能源汽车下乡活动的通知

智能座舱3种交互方式之隐式交互

智能座舱3种交互方式之隐式交互智能驾驶座舱如我们之前文章讲到,他让汽车不简单是一个让你从A移动到B的工具,而是变成懂人类,能与人类互动的智能设备,车内交互可以提高驾驶员的情境意识、

智能驾驶座舱如我们之前文章讲到,他让汽车不简单是一个让你从A移动到B的工具,而是变成懂人类,能与人类互动的智能设备,车内交互可以提高驾驶员的情境意识、信任、舒适性、更好的用户体验以及可用性和安全性。当前汽车从按键交互跨越到了车载显示交互,未来传统车载显示器预计将扩展到具有多模式界面的图形用户界面 (GUI) 显示器,如我们之前文章所诉配备了多种传感技术包括听觉、触觉/触觉、手势、可穿戴传感器、和 AR/VR /混合现实 (MR) 技术,以确保准确预测车内交互。此外,驾驶员或乘客监控对于交互至关重要。车载交互系统需要估计和推断驾驶员/用户的动作、疲劳或困倦等状态、驾驶员的认知状态以及用户的情绪。

通常,人类可以隐式和显式地与智能车辆进行交互。在隐式交互中,用户或驾驶员根据自己的权利进行他们的行为,观察者(汽车)可以推断出用户执行某些行为的状态或意图。例如驾驶员疲劳识别、情绪识别,甚至可以向智能车辆传达某些线索的姿势或姿势估计。

相反,用户打算主动的与车辆进行通信,这就是显式交互例如包括语音命令(了解语言控制汽车AI智能语音101及其供应链)、手势以及通过触觉和显示界面进行的通信。

这个汽车和手机行业是类似,手机1.0时代按键交互,手机2.0时代大屏交互但总体来讲都是显性交互,当代手机配合穿戴设备开启了多传感器隐性和显性交互新时代。

我们先开始讲隐式交互智,能汽车识别驾驶员和乘客的行为和活动对车载交互系统和安全功能具有深远的影响。如果正确分类了驾驶员的意图,则可以在每个时刻将人机交互引导到最合适的模态(视觉/听觉/触觉)。例如如果汽车知道乘客的全身姿势(坐姿、躺姿等),安全功能(例如安全气囊、转向、制动和防撞模式)可以根据最佳及时部署进行定制。在检测到驾驶员分心或疲劳时,智能车辆助手可以选择提供视觉或振动警报。此外,智能车辆助手还可以与驾驶员进行对话以保持他们的警觉。

如果检测到非最佳的身体姿势,驱动的内部可以将驾驶员推向正确的身体姿势,以获得最佳的驾驶注意力。同样,如果发现驾驶员的情绪是愤怒或悲伤,智能车辆助手可以推荐舒缓的音乐,控制车内温度,营造轻松的环境。

此外,如果发现驾驶员无法控制车辆,自动驾驶汽车可以脱离驾驶员,将驾驶员带到安全地带,并与附近的其他车辆 (V2V) 和相关机构 (V2X) 进行通信。

等等毕竟人很奇怪的心理需求是需要别人懂,而隐式交互却是让机器懂你的方式。

本文讲大抵介绍隐式交互的三部分:

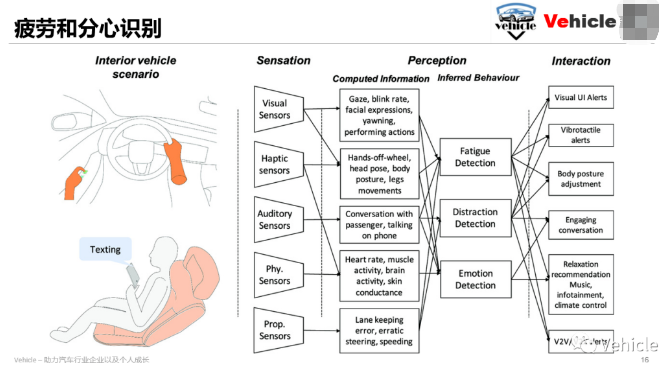

与安全直接相关的疲劳和分心识别,通过现有驾驶员检测和车辆动态状态传感器配合AI算法交互

情绪识别,通过生理传感器配合AI算法

姿态识别,通过视觉传感器配合AI 算法,触觉传感器希望能给大家一些信息和启发

疲劳和分心识别

驾驶员分心是道路事故的主要原因之一,美国国家公路交通安全管理局 (NHTSA) 估计高达 25% 的道路事故是由于某种形式的驾驶员分心而发生的。驾驶员分心或注意力不集中可以定义为“驾驶员注意力不集中表示在没有竞争活动的情况下对安全驾驶至关重要的活动的注意力减少。”分心和疲劳是导致驾驶事故的驾驶员注意力不集中的两种常见形式。

先前的工作已经确定了分心类型的各种区别,例如在路上用手(手动)、眼睛(视觉)和/或头脑(认知)执行第二或第三任务。虽然这些是分心的主要来源,但也可能有其他输入,例如导致分心的听觉刺激。此外,一些活动可能是不同类型的干扰(如发短信)的组合,而驾驶则是手动、视觉和认知干扰的组合。为了检测驾驶员分心,第3节讨论了各种传感技术 . 我们讨论了使用不同传感技术所采用的相关方法和算法,并在本节中讨论了融合一种或多种传感信息的方法。

车辆 IMU、GPS 和外部摄像头等外部传感器可用于推断驾驶行为和不稳定驾驶模式,这可能意味着分心。车速是一项至关重要的测量,在推断干扰时必须与其他传感器测量一起使用。具有 YOLOv4 和 Faster R-CNN等架构的深度神经网络 (DNN)已与外部摄像头一起用于检测交通中的其他车辆和行人以及路标。识别车道和车道保持错误可以作为检测驾驶员分心的指标。例如,逻辑回归模型已被用于区分分心驾驶和使用车道保持错误的正常驾驶。方向盘传感器还提供驾驶员分心的间接指示。

已经演示了一种通过二阶泰勒级数和观察到的角度来预测转向角以计算转向误差的方法。当驾驶员分心时,错误会增加。相比之下,诸如立体摄像头、红外摄像头、ToF 传感器和 RGB-D 传感器等内部视觉传感器已被广泛用于识别驾驶员和乘客的活动、意图和行为。已经比较了用于检测驾驶员分心的最先进的神经网络架构,例如 VGG、AlexNet、GoogleNet 和 ResNet,并且 ResNet 架构似乎优于其他竞争策略。即使是基于单一图像的驾驶员活动识别来检测诸如打电话、发短信、眼睛偏离道路、揉眼睛等活动,也已经使用神经网络进行了演示。

已经提出了一种基于预训练的 CNN VGG-19 架构的端到端网络,该网络对亮度、阴影、相机姿势和驾驶员种族具有鲁棒性,以检测驾驶员分心。此外,面部的聚焦区域也可用于检测分心,例如打哈欠可能意味着疲劳、眼睛偏离道路、眼睛跟踪、眨眼频率等。与 DNN 相比,支持向量机 (SVM) 等机器学习技术也已用于检测闭眼。为了解决稀疏标记数据问题,已经探索了一种称为少数镜头自适应凝视估计 (FAZE) 的新框架,该框架能够学习凝视、头部姿势和外观的紧凑的个人特定潜在表示。然后利用注视估计对分心驾驶和正常驾驶行为进行分类。

内部摄像头也可用于检测手离开方向盘的活动。检测疲劳和分心的其他指标包括闭眼百分比 (PERCLOS)、眼睛离开道路时间、以及使用来自 RGB 相机的视频序列的打哈欠和点头。此外,红外摄像机可用于减轻照明条件的变化。除了视觉传感技术,生理可穿戴传感器,如肌电图 (EMG)、脑电图 (EEG)、心电图 (ECG)、皮肤电活动 (EDA)、眼电图 (EOG) 和心率传感器也已用于检测分心。通过训练 SVM 分类器,EEG 信号可以分为四类,从警觉到嗜睡。

由于 EEG 测量需要将电极放置在驾驶员的头部,因此它们的实际用例很少;但是,某些新颖的入耳式 EEG 可能会用于实际用例。心电图测量心脏的电活动,驾驶员的情绪、心理活动和体力消耗会影响心率。EOG 传感器用于记录眼球运动,并可用于检测疲劳和嗜睡。例如,当眼睛的上眼睑和下眼睑之间的接触持续约 200-400 ms 时检测到眨眼,如果眼睛保持闭合超过 500 ms 时检测到微睡眠,并且可以通过 EOG 检测到。研究表明,在疲劳开始时,EMG 信号的幅度逐渐减小,可以通过 EMG 设备检测到。生理传感器本质上是侵入性的,这抑制了它们的实际使用。然而,诸如 Neuralink 脑机接口之类的新技术,其中将无线设备直接植入颅骨,可能会提供大脑活动和认知分心的细节,这可以帮助驾驶以及高度自动驾驶。

首页 下一页 上一页 尾页上一篇:丰田:带着老客户一同步入电动时代

-

一文详解驾驶员疲劳预警系统2022-03-23

-

剔除安全驾驶员!Waymo计划在旧金山推出完全自动驾驶服务2022-03-23

-

驾驶员仿真平台(DIL)及其应用2022-03-07

-

PreScan快速入门到精通第三十六讲:PreScan中使用车道线传感器2022-03-07

-

PreScan快速入门到精通第三十五讲:车道线识别传感器-ALMS车道线传感器2022-03-07

-

一氧化碳传感器在电动汽车及储能电站中的应用2022-03-04

-

PreScan快速入门到精通第三十四讲:基于PreScan进行超声波雷达传感器仿真2022-03-02

-

自动驾驶和环境感知传感器的数字孪生技术和应用2022-03-02

-

自动驾驶的未来,多传感器融合方案分析2022-02-28

-

基于MATLAB&SIMULINK开发自动驾驶系统第三讲之鸟瞰范围内可视化传感器数据和物体跟踪2022-02-22

-

基于MATLAB&SIMULINK开发自动驾驶系统第一讲之传感器配置和坐标系转换2022-02-22

-

2021动力电池行业火出圈 2022头部企业扎堆上市再圈地2022-02-08

-

燃料电池车厂商可以采用哪些氢气传感器监测氢气泄漏?2022-01-25

-

自动驾驶会替代人类驾驶员吗?如何实现更理想的人机交互?2022-01-21

-

纬湃科技赢得北美头部汽车制造商超10亿欧元高压逆变器大单2022-01-12